О валидности (точнее, невалидности) центров оценки

Этот пост — продолжение моей дискуссии с Евгением Лурье. Начало здесь Про Российский стандарт центра оценки: вопросы аналитика к авторам. Читать этот пост вы не будете (дай бох Евгений осилит), поскольку здесь много погружения в детали, поэтому коротко о главном.

Цель поста простая: показать, что в Российской практике НЕТ ни одного нормального доказательства валидности центров оценки — валидности, которая бы показывала взаимосвязь оценок в центре оценки и бизнес показателей. А авторы Стандарта вводят рынок в заблуждение. Намеренно или по собственному непониманию — другой вопрос.

И еще оцените мою трудоспособность: я трачу кучу времени на изучение источников, которые сам оппонент едва ли читал, о чем ниже. Я не уверен, что готов буду в дальнейшем тратить свое время на изучение сомнительных цифр, которыми кормит рынок Евгений Лурье.

Коллеги, также я обращаюсь к тем из вас, кто проводит ассессмент центры в компании, с предложением о валидизации результатов центров оценок. Я помогу вам оценить, насколько результаты центра оценок коррелируют с бизнес показателями, а рынок получит еще один кейс (с вашего разрешения, конечно).

Ну итак

Главный вопрос дискуссии — валидность центров оценки.

В Российском стандарте центра оценки есть такая фраза:

«Валидность ЦО была ранее доказана на материале многочисленных исследований.»

Я к этой фразе задал несколько вопросов:

- Относится ли эта фраза также к критериальной валидности?

- Если да, то приведите «материалы многочисленных исследований», доказывающих критериальную валидность?

- Поскольку речь идет о Российском стандарте центра оценки, то не могли бы вы привести материалы многочисленных исследований именно на российских кейсах?

Евгений дал кучу ссылок, но реальных кейсов про валидность центров оценки всего три.

Евгений, три кейса это многочисленные?

ВСЕГО ТРИ КЕЙСА, Карл!!!, если вам нужно подготовиться для того, чтобы найти больше кейсов, то чего стоит ваша фраза в Стандарте про «многочисленные….». Вам не кажется, что вы вводите в заблуждение рынок своими «многочисленными» исследованиями по валидизации центра оценка?

На эти три кейса у меня есть кейс Сбербанка, где результаты Центра Оценки коррелировали с KPI на уровне 0, 0.

Первые два кейса приводятся в посте Про валидность ассессмент центров, а третий кейс — кейс Экопси — в посте Валидность и надежность российских Центров оценки.

Итого три кейса:

- Кейс Ерофеева, 2012

- Кейс Сидоренко, 2013

- Кейс Экопси.

Из этих трех кейсов про критериальную валидность центров оценки (валидность, которая показывает взаимосвязь между результатами центра оценки и результатами бизнеса) кейс Сидоренко, поэтому я приберегу его напоследок и покажу с особым удовольствием (Сам Евгений с особым удовольствием цитирует результат кейса: «Центр оценки правильно предсказывал успешность прохождения стажировки в 77.5% случаев». А я вам с удовольствием покажу, что реально стоит за этими 77, 5 % , чтобы у вас не перехватывало дух от таких высоких результатов. Дьявол как всегда в деталях.)

Кейс Ерофеева

Это вообще непонятный кейс. Евгений Лурье приводит фразу: «Сравнивался Итоговый Оценочный Рейтинг, полученный в ходе ЦО, с усредненными оценками из интервью по компетенциям, которые проводили сотрудники службы персонала……. получен средний коэффициент корреляции 0.63 при р=0.01». По русски это так: одновременно психологи и HR компании оценивали чуваков, а потом сверили оценки и выяснили, что оценки бьются на 0, 63. Поздравляю. В этом случае готов согласиться с тем, что оценки могут совпадать: в чем здесь проблема? Как сам Евгений многократно любит приводить пример, что факторный анализ «сворачивает» все компетенции в 1-2 фактора, которые больше про «понравился / не понравился», чем про реальные скилсы, так и в этом случае вполне допускаю, что и те, и другие оценили способность держаться и все такое. Как это связано с валидностью центра оценки? Сам Ерофеев пишет про другое, чем Евгений:

«Дополненные имитационными упражнениями и мультимодальным интервью батареи поведенческих тестов когнитивных способностей и социального интеллекта позволили разработать, валидизировать и внедрить три программы центров оценки ACL (Assessment Center LASPI). Критериальная валидность различных программ изменяется в интервале 0.60-0.67 ( среднее: r= 0.63, р=0.01) (Ерофеев, 2010).»

В самом тексте вообще НИЧЕГО не говорится про бизнес результаты людей. Из самого описания (стр 150, почитайте) следует скорее, что критериальная валидность — это про успешность выполнения тестовых заданий, которые сам же автор и придумал:

«Первая исследовательская программа посвящена развитию экспериментальных лабораторных методов исследования ситуативных (относящихся к отдельному по-ступку в попытке достичь цель) и ситуационных (относящихся к серии поступков, допустимых в конкретной ситуации) поведенческих параметров рациональности стратегии поиска границы возможностей в условиях многоальтернативного выбора.»

Поэтому в качестве резюме: этот кейс вообще непонятно про что. Евгений говорит про сметчивание оценок, сам автор про другое. Резюме: я не могу засчитать этот кейс в копилку валидности центров оценки.

Кейс Экопси

В 2012 году сотрудники Экопси Попов и Лурье опубликовали статью в журнале Организационная психология. Статья немаленькая, но весь результат (стоило огород городит?) в фразе:

На первом этапе анализа изучались отсроченные корреляции результатов ЦО в 2002–2003 гг. и результатов ЦО в 2006–2012 гг. По результатам анализа тест-ретестовый коэффициент корреляции Спирмена для общего оценочного рейтинга (ООР) Центра оценки составил 0.47 при N = 124 и p < 0.001. Оценки по отдельным компетенциям также обнаруживают довольно тесный паттерн корреляций друг с другом (разброс корреляций от 0.06 до 0.44).

К однозначным плюсам нужно отнести тот факт, что здесь указан, какой именно коэффициент корреляции указан. А далее в таблице показываются корреляции между конкретными компетенциями, которые уже показывают настоящую картину:Берем компетенцию из ассессмент центров 2002-2006 годов «Взаимодействие в многофункциональной команде». Это компетенция коррелирует с оценками по компетенции «Командная работа» 2006-2012 года на уровне 0, 2 — маловато, не правда ли? Но эта же компетенция коррелирует с оценками по компетенции 2006-2012 года «Управленческая самостоятельность» на уровне 0, 33. Странно? Вроде «свои» компетенции должны коррелировать выше. А все дело в том, что в центре оценки оценивают не конкретные компетенции, а общее впечатление или чего то там. И связь между оценками спустя 6 лет понятна. Во-первых, ассессоры сравнивают одних и тех же людей (124 человека), а коэффициент Спирмена — ранговый коэффициент, он как раз научен ловить отличия того, как у нас расставляют по рангам людей. Готов поспорить, если бы эти же люди работали в других компаниях, их оценивали в других составах на центре оценки, то такой коэффициент получен бы не был. Обобщенный коэффициент показал 0, 47, а отдельные компетенции такого не показали, потому что усреднение как раз работает на руку коэффициенту корреляции Спирмена. И кроме того, 0, 47 это не так много. Я бы в качестве валидизации рекомендовал провести такую процедуру: возьмите этих спецов и попросите их рассказать интересную историю, в качестве оценщиков возьмите первых попавшихся зевак, попросите этих зевак оценить, насколько интересным было рассказ спеца по разным категориям. Через шесть лет пусть эти же спецы опять расскажу историю, но оценщики / зеваки будут другими. Они опять оценят. И мы стопудово найдем корреляцию Спирмена в этих оценках. (это и есть валидность центра оценки?)И главное: и что нам доказывает это исследование? То, что спустя несколько лет одни и те же люди будут выстроены примерно в одной и той же иерархии оценок? Ну поздравляю, для психологии это, наверное, высокий результат. Резюме: как это все связано с валидностью центров оценки?

Кейс Сидоренко. Самое вкусное

Оцените мой труд: я осилил книгу Сидоренко про центры оценки. Евгений презентирует этот кейс по валидизации центра оценки так: «Центр оценки правильно предсказывал успешность прохождения стажировки в 77.5% случаев». Кейс ценен тем, что это про реальную связь с бизнес оценками. Я вам рекомендую самостоятельно с 90-й страницы почитать. И тут выясняется много деталей:)

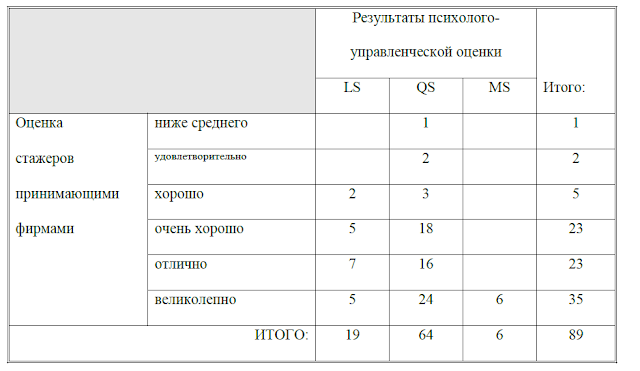

По трем другим группам, общей численностью в 89 человек, мы располагаем только общими оценками принимающих фирм, данными в шести балльной шкале: “ниже среднего”, “удовлетворительно”, “хорошо”, “очень хорошо”, “отлично”, “великолепно”. Данные оценки лишь условно можно назвать критериальными мерами, поскольку их объективность и независимость вызывает определенные сомнения.

Итого у нас есть 89 менеджеров, по которым есть оценки компании (от ниже среднего до великолепно) и оценки по компетенциям. Заметьте, автор просто в тренде: «Данные оценки лишь условно можно назвать критериальными мерами, поскольку их объективность и независимость вызывает определенные сомнения.». В тренде, потому что главный аналитик Экопси Г.Финкельштейн прямо указывает на то, что KPI фу фу бяка, нельзя на это ориентироваться, они, KPI, выставляются непонятно кем, зачем, незнако как. Ему вторит и гендир Экопси П. Безручко, а Евгений Лурье так вообще не скрывает своего отношения к KPI Обычно замер KPI существенно хуже по качеству, чем стандартизированный инструмент оценки поведения. Да ещё и содержит солидную долю политики и платы за лояльность. Т.е. мы профи и спецы, а эти дураки из бизнеса не умеют оценивать работу персонала, а ставят оценки исключительно за лояльность. А мы только за бабло, которые нам за ассессмент центры отваливают объективны и непредвзяты. Те по сути позиция по валидации центра оценки звучит так: нам вообще не надо валидизировать центры оценки, мы спецы сами в себе. Сферический конь в вакууме.

Я с такой позицией Экопси не согласен. Но бох с ним, давайте посмотрим, что накопал Сидоренко:

Коэффициент корреляции между оценками ТЕХНОЛОГИИ и принимающих компаний невысок, но статистически значим: 0,236 при значимости 0,045.

Вот здесь можно вообще закрывать книгу и не читать, если бы я конечно верил, что автор в математике разбирается. Если бы доверял, то сказал бы 0, 236 при p-value 0, 045 — суши весла. Закрывай тему валидизации центров оценки. Спасибо автору за честность. Но реальная картинка показана на стр 91 (и результат еще хуже, чем 0, 236)

- В строках: оценки компанией стажеров.

- В колонках: оценки по центру оценки.

Цитирую: «оценка “ниже среднего” примерно соответствует категории

LS, а “великолепно” — MS»

Ну т.е. по сути дела LS — плохо, QS — средне, MS — круто.

Так вот, ВСЕ, кто показал себя плохо (оценки ниже среднего и удовлетворительно) покали в группу средних оценок по компетенциям. И 19 человек они вообще не рекомендовали брать, а эти люди показали оценки от хорошо до великолепно. Да, 6 человек великолепных совпали, но и 5 они отправили отдыхать, а те показали великолепно по итогу.

Строго говоря, для этой компании вообще нужен инструмент отсева плохих, если они берут тех, кто показал оценки от хорошо и выше. У них таких трое, это 3, 3 %. И эти 3, 3 % не смог уловить ассессмент центр. Presicion равен 0, 0.

Но давайте сами пофантазируем, а что, если компания будет брать тех, к кого только отлично и великолепно?

| LS | QS | MS | ||

| 0 | 7 | 24 | 0 | 31 |

| 1 | 12 | 40 | 6 | 59 |

| 19 | 64 | 6 | 90 |

Давайте получим из нее матрицу неточностей

| LS | QS / MS | ||

| 0 | 7 | 24 | 31 |

| 1 | 12 | 46 | 58 |

| 19 | 70 | 89 |

Логика, очень проста в данном случае: Если кандидат показал на центре оценке результат QS или MS, то он с вероятностью 0, 657 % будет оценен как хорошо или великолепно (делим 46 на 70). А если LS, то 63 % (12 делить на 19). Какое качество модели в данном случае? говно Не очень хорошее. Для спецов: Хи квадрат, 0, 83 или типа того. Евгений, если бы вы посетили мой семинар Семинар BigData для HR-директоров, Москва, я бы вас научил считать реальную связь между результатами центров оценки и бизнес показателями, т.е. валидизировать центры оценки (скорее невалидизировать). Вы же на сегодня либо сами просто не понимаете смысла цифр, которые вы слышите про валидизацию центров оценки, либо умышленно скрываете истинную картину, что еще хуже. Отсюда возникает гипотеза, что бывший коллега Евгения Лурье Шатров Вопросы к тесту управленческого потенциала Экопси примерно на таком же уровне понимает логику валидизации центров оценки и тестов.

Источник : edwvb.blogspot.com